Mnoho bloggerů hledá odpověď na tuto otázku: „Jak se zbavit duplicitních stránek?“, S cílem odstranit duplicitní stránky svého webu z výsledků vyhledávačů. Duplicitní stránky spadají do indexu vyhledávačů, kde jsou přítomny spolu s hlavní propagovanou stránkou.

Může existovat spousta takových stránek současně, vyhledávač bude muset ve výsledcích vyhledávání umístit stejné stránky. Za tímto účelem může vyhledávací systém uvalit sankce na hlavní stránku a snížit ji ve výsledcích vyhledávání. Duplicitní stránky tedy mají škodlivý účinek na propagaci stránek ve vyhledávači.

Obsah:- Můj příběh o pořizování duplicitních stránek

- Vyhledejte duplicitní stránky

- Zákaz indexování v souboru robots.txt

- Přidání parametru answertocom do nástrojů pro webmastery

- Doplněk WordPress Thread Comment pro stromové komentáře

- WordPress SEO plugin od Yoast pro odstranění replikomů

- 301 přesměrování k odstranění replikomu

- Nastavení pluginu SEO

- Ruční odstranění duplicitních stránek

- Jak jsou duplikáty odstraněny na mém webu

- Další způsob, jak se vypořádat s duplicitními stránkami

- Závěry článku

Duplicitní stránky mohou kopírovat celý obsah nebo pouze částečný obsah hlavní stránky. Konkrétně samotný WordPress CMS vytváří, v některých případech, duplicitní stránky, například známý „replikom“ (komentář, odpověď na komentář, replika).

Pokud jsou na vašem webu obsaženy komentáře stromů, vytvoří v tomto případě každý komentář duplikát stránky. Pokud jsou tedy v indexu vyhledávacích strojů přítomny duplicitní stránky webu, bude nutné tyto stránky z výsledků vyhledávacích strojů odstranit..

Přítomnost duplicitních stránek ve vyhledávání poškozuje web, když je propagován ve vyhledávačích. Vyhledávače snižují polohu stránek, snižuje se tzv. Hmotnost stránky, indexování stránek se zhoršuje atd..Vyhledávací modul Google věnuje zvláštní pozornost přítomnosti duplicitních stránek a snižuje tak pozici stránek v přítomnosti velkého počtu z nich. Už nebudu teoretizovat toto téma, ale spíše vám povím o tom, jak bojuji s duplikáty stránky, a to pomocí příkladu mého webu - vellisa.ru.

Můj příběh o pořizování duplicitních stránek

Na samém začátku jara 2013 se můj web stal rok starý, v té době byl provoz webu přibližně 2000 návštěvníků denně. Pak se provoz na stránky začal klesat. Již v polovině května návštěvnost stěží přesáhla 1 000 návštěvníků denně..

Na jaře 2013 mnoho blogerů kvůli zavedení nových algoritmů snížilo návštěvnost od Googlu. Na mém webu se provoz z vyhledávače Google snížil asi o 40%. V mém případě byl pokles provozu ovlivněn zavedením nových algoritmů a také některými změnami, které jsem v té době na svém webu provedl.

Když jsem si myslel, rozhodl jsem se vrátit předchozí provoz na svém webu. Přes léto jsem tento úkol dokončil, v září se mému webu opět podařilo dosáhnout průměrného provozu 2 000 návštěvníků denně. Provoz na mých stránkách dále rostl..

Všechno se zdá být v pořádku, ale faktem je, že nárůst návštěvnosti nastal hlavně díky vyhledávacímu nástroji Yandex. Pokud dříve byl poměr návštěvníků, kteří na web přišli z Yandexu a vyhledávání Google, 3: 1 (přibližný poměr, zhruba) ve prospěch Yandexu, což zhruba odpovídá podílu vyhledávačů v Runetu, pak se tento poměr zvýšil na 5: 1. Byla silná závislost na jediný vyhledávač.

Docházka od společnosti Google rostla velmi pomalu, teprve na jaře 2014 dosáhla úrovně minulého roku. Ale v té době, celý rok, jsem psal nové články. Ukazuje se, že Yandex adekvátně reagoval na přidání nových článků na webu, které o Googlu nelze říci.

V prosinci 2013 jsem musel na svůj web nainstalovat novou šablonu, protože v předchozím tématu jsem nemohl změnit strukturu svého webu. Stejně jsem to musel udělat.

Poté jsem upozornil na duplicitní stránky v indexu vyhledávačů. Předtím jsem o tomto problému věděl, četl jsem o tom, jak jej vyřešit, ale ještě jsem nic neudělal..

V žádném případě bych na svém webu nevypínal stromové komentáře, protože by to bylo pro návštěvníky webu nepohodlné a nechtěl jsem použít pluginy k odstranění duplicitních stránek..

Výsledkem byl, že kód byl nainstalován do souboru htaccess a ze souboru robots.txt byly odstraněny některé direktivy (další informace o tom, co jsem udělal níže). Počet duplicitních stránek na mém webu se ve výsledcích vyhledávače postupně snižoval.

V březnu 2014 jsem do nástrojů pro webmastery Google přidal parametr „repltocom“ a v květnu jsem tam přidal další parametr: „feed“.

V současné době na mém webu nebyly ve výsledcích vyhledávače Google žádné duplicitní stránky, které mají proměnnou repliku v jejich adrese, ale předtím existovalo velké množství takových stránek (několik tisíc).

Nakonec jsem byl příjemně překvapen nárůstem, asi dvakrát větší návštěvností od Googlu. Nyní se poměr mezi vyhledávači zvýšil na 2: 1 ve prospěch Yandexu.

Z vlastní zkušenosti jsem se tedy dozvěděl, jaký vliv může mít na propagaci webových stránek, přítomnost duplicitních stránek v indexu vyhledávače..

Je pravda, že bude nutné vzít v úvahu, že vyhledávače řadí stránky do výsledků výsledků vyhledávání mnoha způsoby. Pravděpodobně tedy nebudete mít významný nárůst provozu na vašem webu. V každém případě bude mít odstranění duplicitních stránek z výsledků vyhledávání příznivý dopad na váš web..

Vyhledejte duplicitní stránky

Chcete-li na svém webu vyhledat duplicitní stránky, zadejte do vyhledávacího pole výraz „site: vellisa.ru“ (namísto „vellisa.ru“ zadejte název svého webu). Přejděte na poslední stránku výsledků vyhledávání, v tomto případě mám 19 stránek. Zapamatujte si číslo této stránky, abyste se na ni později mohli rychle dostat.

Na poslední stránce výsledků vyhledávání se pod posledním výsledkem výsledků vyhledávání zobrazí oznámení, ve kterém jste informováni, že vyhledávač skryl některé výsledky, které jsou velmi podobné těm, které již byly uvedeny výše. Dále klikněte na odkaz „Zobrazit skryté výsledky“.

Poté se znovu otevře první stránka výsledků vyhledávání. Jděte přímo na stránku, na kterou si vzpomínáte, v mém případě je to stránka 19. Na této nebo na další stránce se zobrazí duplicitní stránky vašeho webu.

Tento obrázek zobrazuje duplicitní stránky, které mají v adrese URL odkazy „feed“ a „tag“. Také ve výsledcích vyhledávání mohou být duplikáty s „repltocom“, „stránkou“ as některými dalšími parametry.

Dalším velkým problémem, pokud web používá stromové komentáře, je obrovské množství stránek s proměnnou repltocom generovanou samotným WordPress CMS..

Dostupnost stránek s replikou můžete zkontrolovat tímto způsobem: do vyhledávacího pole Google zadejte výraz „site: vellisa.ru repltocom“ (bez uvozovek). Místo „vellisa.ru“ vložte název svého webu.

Na mém webu nejsou duplicitní stránky s replikou, přestože na mém webu jsou stromové komentáře. Jako příklad uvedu stránku jedné z mých přítelkyní Julie (inet-boom.ru), doufám, že se za to neurazí.

Na tomto obrázku na samém konci odkazu za adresou stránky uvidíte konec odkazu - „? Replytocom = 3734“. Čísla na konci adresy se budou měnit v závislosti na čísle komentáře.

V indexu vyhledávače může být velké množství takových stránek. Proto bude nutné bojovat s repltocomem.

Co bude třeba udělat?

- Vyhledejte duplicitní stránky v indexu vyhledávače.

- Zavřete potřebné parametry z indexování v souboru robots.txt.

- Přidejte nastavení na panel nástrojů Google Webmaster.

Tyto požadavky bude muset být splněny bez selhání. Zbytek akcí bude záviset na metodě, kterou se rozhodnete bojovat proti duplikátům stránky..

Budete muset přidat svůj web do nástrojů pro webmastery Google a Yandex, abyste vyřešili problém zbavení se duplicitních stránek pomocí těchto nástrojů vyhledávače..

Zákaz indexování v souboru robots.txt

Chcete-li zakázat indexování určitých parametrů, které ovlivňují vzhled duplicitních stránek ve vyhledávání, jsou do souboru robots.txt přidány příkazy. Při použití direktivy Zakázat je vyhledávacím robotům vydán příkaz k zákazu indexování.

Příkazy zabraňující indexování v souboru robots.txt mohou vypadat asi takto (v tomto příkladu část souboru):

Směrnice s otazníkem (?) Jsou obvykle přítomny, pokud jsou na webu vytvářeny tzv. CNC odkazy, kterými se mění URL webové stránky. K dispozici je také příkaz k zákazu indexování odkazů s proměnnou repltocom.

Pokud vyhledávací stroj Yandex obecně vyhovuje směrnicím zadaným do souboru robots.txt, je s vyhledávacím modulem Google vše mnohem složitější. Roboti Google indexují vše, a to i přes zákazy uvedené v souboru robots.txt.

Plugin pro optimalizaci SEO má možnost uzavřít záhlaví, tagy, archivy, vyhledávací stránky atd. Pomocí značky „noindex“. Pravda, tyto pokyny ne vždy následují vyhledávací roboti.

Přidání parametru answertocom do nástrojů pro webmastery

V nástroji pro webmastery Google přejděte na stránku Nástroje pro webmastery. V pravém sloupci „Panel nástrojů webu“ nejprve klikněte na tlačítko „Prohledat“ a poté na tlačítko „Nastavení adresy URL“.

Na této stránce můžete přidat nové parametry nebo změnit již přidané parametry pro zpracování pomocí vyhledávacích robotů Google. V závislosti na nastavení bude prolézací modul Googlebot ignorovat určité parametry při zadávání stránek do indexu vyhledávače.

- Chcete-li přidat nový parametr, klikněte na tlačítko „Přidat parametr“.

- Poté se otevře okno „Přidat parametr“..

- Do pole parametrů (velká a malá písmena) přidejte nový parametr, v tomto případě „repltocom“.

- Na otázku: „Mění tento parametr obsah stránky, který uživatel vidí?“, Odpovíte: „Ano, parametr mění nebo reorganizuje nebo omezuje obsah stránky“.

- Při zodpovězení otázky: „Jak tento parametr ovlivňuje obsah stránky?“, Vyberte možnost odpovědi: „Jiné“.

- Na otázku: „Které adresy URL obsahující tento parametr by měl Googlebot procházet“, odpovězte: „Žádné adresy URL“.

- Poté klikněte na tlačítko "Uložit".

Podobně můžete přidat další parametry. Pokud je parametr již v seznamu a pak chcete změnit jeho nastavení, musíte kliknout na odkaz „Změnit“.

Po přidání parametru answertocom na panel webmasterů budete muset ze souboru robots.txt odstranit něco jako direktivu „Disallow: / *? Replytocom“ (pokud je v souboru robota), aby googlebot následoval odkazy s tímto parametrem a odstranil je z indexu.

Pokud váš web nemá duplicitní stránky s tímto parametrem, můžete takovou směrnici ponechat v souboru robots.txt.

Z indexu vyhledávače budou odstraněny postupně duplicitní stránky. Pokud existuje mnoho duplicitních stránek, pak v tomto případě bude proces odstraňování duplicitních stránek trvat poměrně dlouho, možná i během několika měsíců.Doplněk WordPress Thread Comment pro stromové komentáře

Vzhledem k tomu, že vzhled replikomu je usnadněn poznámkami ze stromu, někteří uživatelé je obvykle na svém webu deaktivují. Po deaktivaci stromových komentářů, zejména pokud jsou články na webu aktivně komentovány, se získá velmi nevhodná navigace. Návštěvníkovi někdy není vůbec jasné, kdo, kde, komu, co odpověděl.

Plugin WordPress Thread Comment řeší problém stromových komentářů v WordPress. Na webu zůstávají komentáře stromů bez přidaných proměnných typu repltocom. Plugin zobrazí odkaz s komentářem prostřednictvím javascriptu, takže vyhledávače tento odkaz neindexují.

Nové proměnné replikomu se již nebudou objevovat v indexu vyhledávače a staré proměnné bude muset být postupně odstraněny z indexu vyhledávače..

Osobně se mi nelíbil vzhled komentářů v tomto pluginu. Tento plugin jsem na svém webu nepoužil. Všiml jsem si, že doplněk WordPress Thread Comment pro boj s replikou doporučil Alexander Borisov.

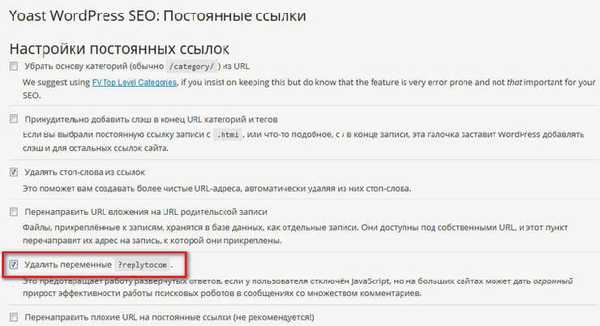

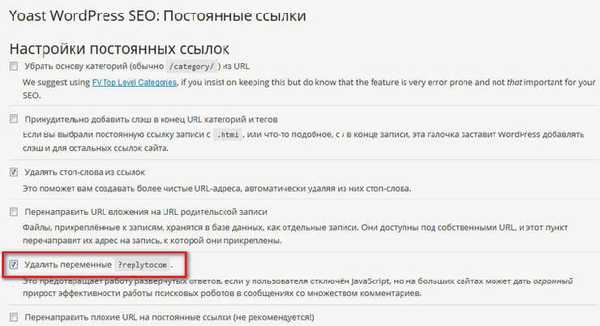

WordPress SEO plugin od Yoast pro odstranění replikomů

WordPress SEO by Yoast plugin, poměrně výkonný plugin pro optimalizaci webu SEO, mimo jiné vám umožňuje odstranit repltocom proměnné z webu. Zároveň na vašem webu zůstanou komentáře stromů.

Po instalaci pluginu WordPress SEO od Yoast na svůj web, v nastavení pluginu, v sekci „Permalinky“, budete muset aktivovat „Odstranit proměnné? Replytocom“.

Poté budou z indexu Google odstraněny postupně duplicitní stránky s replikátem „snot“.

Protože na mém webu je nainstalován plugin Vše v jednom SEO Pack a z nějakého důvodu se nechci přepnout na WordPress SEO pomocí vašeho pluginu, zatím jsem tuto možnost nepoužil k boji s duplikáty stránek.

301 přesměrování k odstranění replikomu

Toto je pravděpodobně nejradikálnější způsob, jak se vypořádat s replikou. Použil jsem tuto konkrétní metodu.

Po změně šablony Larisa Web-Cat navrhla, abych použil 301 přesměrování k boji proti replikomům. Před změnou šablony na webu jsem se neodvážil použít tuto metodu.

Teď mohu říci, že při použití přesměrování 301 a také po některých akcích, o kterých budu psát níže, se můj web úspěšně vypořádal s replikáty duplikátů.

Na tomto obrázku můžete vidět, že na mém webu nejsou duplicitní stránky s proměnnou repltocom, přestože na mém webu jsou stromové komentáře bez použití speciálních pluginů.

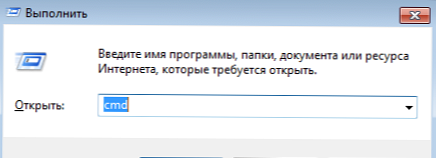

Chcete-li použít přesměrování 301, budete muset do souboru „htaccess“, který je umístěn v kořenové složce vašeho webu, vložit speciální kód. Kořenová složka webu je složka vašeho webu, která obsahuje složky „wp-admin“, „wp-content“, „wp-include“ atd..

Do souboru htaccess pod řádek "RewriteBase /" budete muset vložit následující kód:

RewriteCond% QUERY_STRING repltocom = RewriteRule ^ (. *) $ / $ 1? [R = 301, L]Pozor! Před vložením tohoto kódu je původní soubor htaccess v počítači. Pokud uděláte chybu, něco se pokazí, pak můžete nahradit upravený soubor htaccess původním souborem pomocí správce souborů na vašem hostingu nebo přes FTP pomocí programu FileZilla..

Pokud se vyskytne problém, místo vašeho webu se zobrazí „bílá obrazovka smrti“. Nahrazení upraveného souboru původním souborem htaccess obnoví funkčnost vašeho webu.

Po vložení kódu budete muset zkontrolovat funkci přesměrování 301. Nejprve musíte do adresního řádku prohlížeče vložit odkaz obsahující repltocom a poté zkontrolovat výsledek přechodu. Po přechodu se bude muset odkaz na otevřené webové stránce změnit na původní odkaz, který v adrese URL neobsahuje proměnnou replikomu..

Dále budete muset udělat dvě další věci. Nejprve budete muset odstranit směrnice ze souboru robots.txt obsahující zákaz indexování stránek s otazníkem. Pokud použijete tuto metodu, směrnice se odstraní..

Poté budete muset do parametru „Nástroje pro webmastery Google“ přidat parametr answertocom, jak jsem psal výše v článku.

Nastavení pluginu SEO

Chcete-li zabránit indexování archivních stránek, kategorií, značek, 404 stránek, vyhledávacích stránek, stránkování (navigace po stránce), v pluginu Vše v jednom SEO Pack budete muset aktivovat položky, abyste přidali argumenty noindex, follow a noindex, nofollow (pro navigaci po stránce).

V zásuvném modulu WordPress SEO by Yoast budou parametry indexování pro vyhledávače vypadat takto: noindex, postupujte.

Nyní musíte být trpěliví a počkat, až Google odstraní duplicitní stránky z indexu. Pokud nechcete čekat dlouho, nebo pokud na vašem webu zbývá jen velmi málo duplicitních stránek, můžete jejich odstranění urychlit..

Ruční odstranění duplicitních stránek

Do Nástrojů pro webmastery můžete ručně přidat odkazy na duplicitní stránky a odstranit je z indexu vyhledávače. Když ve výsledcích vyhledávače na mém webu nezbylo tolik duplicitních stránek, přidal jsem také výsledky nalezené k rychlejšímu odebrání z indexu ručně..

- Na stránce „Nástroje pro webmastery“ v pravém sloupci „Panel nástrojů webu“ nejprve klikněte na tlačítko „Index Google“ a poté na tlačítko „Odstranit adresy URL“..

- Poté se otevře stránka „Odstranit adresy URL“. Na této stránce budete muset kliknout na tlačítko „Vytvořit nový požadavek na odstranění“.

- Pod tlačítkem se otevře pole, do kterého se vloží odkaz. Poté budete muset kliknout na tlačítko „Pokračovat“.

- Poté se otevře nová stránka, na které se zobrazí smazaná adresa URL. V položce Důvod vyberte tuto možnost: „Odstranit stránku z výsledků vyhledávání az mezipaměti.“ Poté klikněte na tlačítko „Odeslat požadavek“.

- Na stránce Smazat adresy URL uvidíte přidané odkazy čekající na smazání. Přesně tímto způsobem můžete přidat následující odkaz a odstranit jej z výsledků vyhledávání az mezipaměti vyhledávače Google.

Problém existuje, může mít negativní dopad na propagaci webových stránek, takže správce webu se bude muset zbavit duplicitních stránek, aby dosáhl pozitivního výsledku.

Od zveřejnění tohoto článku uplynul měsíc, nyní je čas doplnit publikaci novými informacemi.

Jak jsou duplikáty odstraněny na mém webu

Nyní vám přesně řeknu, jak se v tuto chvíli provádí boj proti duplikátům stránek na mém webu.

- Ze souboru robots.txt jsem odstranil některé direktivy, které umožňují vyhledávacím robotům přístup do určitých adresářů mého webu.

- V pluginu pro optimalizaci SEO (AIOSP) jsem si všiml bodů pro přidání robotů s metaznačkami na odpovídající stránky webu. Prohledávač, který se přesune na takovou stránku, uvidí zakazující metaznačku a tuto stránku nebude indexovat.

K tomu byl otevřen přístup na určité stránky v souboru robotů, takže robot šel na tuto stránku a viděl následující metaznačky:

meta name = "robots" content = "noindex, nofollow" meta name = "robots" content = "noindex, follow"

Vyhledávací robot proto stránku indexovat nebude s takovými značkami metadat. Dřívější výsledky v indexu stránky budou z výsledků vyhledávače postupně odstraněny..

- Na panel webmasterů Google byly přidány možnosti Answertocom.

- Do souboru htaccess jsem přidal následující kód:

RewriteCond% QUERY_STRING repltocom = RewriteRule ^ (. *) $ / $ 1? [R = 301, L] RewriteRule (. +) / Feed / $ 1 [R = 301, L] RewriteRule (. +) / Comment-page / $ 1 [R = 301, L] RewriteRule (. +) / Trackback / $ 1 [R = 301, L] RewriteRule (. +) / Komentáře / $ 1 [R = 301, L] RewriteRule (. +) / Příloha / $ 1 [R = 301, L] RewriteCond% QUERY_STRING ^ attach_id = [NC] RewriteRule (. *) $ 1? [R = 301, L]

Tento kód zahrnuje 301 přesměrování s replikomem, stejně jako přesměrování s dalšími parametry, které jsem převzal z webu Alexandra Borisova. Jak to chápu, autorem přesměrování pro další parametry je slavný blogger Alexander Alaev (Alaich).

Odpovídající direktivy (feed, komentáře, zpětné sledování atd.) Pro parametry, které byly přidány do souboru htaccess, byly ze souboru robots.txt odstraněny..

Poté bude vyhledávací robot, který přejde na duplikovanou stránku, která má v adrese URL takové parametry, přesměrován pomocí přesměrování 301 na původní stránku mého webu..

- Do souboru function.php byl přidán kód, který zabraňuje objevování nových záběrů s replikomem, který na internetu našel návštěvník mého webu Anton Lapshin:

function Repla_reply_to_com ($ link) return preg_replace ('/href=\'(.*(\?|&)replytocom=(\d+)#respond)/', 'href = \' # comment- $ 3 ', $ link ); add_filter ('comment_reply_link', 'Repla_reply_to_com');Budete muset tento kód vložit do souboru „Topic Functions“ (features.php) před závěrečnou značku?>.

Po vložení kódu, když umístíte kurzor myši na tlačítko „Odpovědět“ v komentářích, proměnná responetocom se již nebude zobrazovat ve odkazu, který bude viditelný v levém dolním rohu okna prohlížeče. Nové odkazy s tímto parametrem proto nebudou přidány do indexu vyhledávacích strojů.

Před provedením změn nezapomeňte zálohovat soubor funkcí motivu..

Všechna tato nastavení fungují hlavně pro vyhledávač Google. V Yandexu je poměr počtu stránek načtených robotem a stránek při vyhledávání na mém webu v tuto chvíli optimální.

Další způsob, jak se vypořádat s duplicitními stránkami

Na internetu jsem našel jiný způsob, jak odstranit duplicitní stránky z výsledků vyhledávání. Pomocí kódu, robotů metadat noindex, nofollow bude přidán na určité stránky webu, aby se zabránilo indexování takových stránek.

Tento kód je vložen do souboru function.php ihned poté

funkce meta_robots () if (is_archive () nebo is_category () nebo is_feed () nebo is_autor () nebo is_date () nebo is_day () nebo is_day () nebo is_year () nebo is_tag () nebo is_tax () nebo is_attachment () nebo is_paged () nebo is_search ()) echo "". ''. "\ n"; add_action ('wp_head', 'meta_robots');Po přidání tohoto kódu budete muset v pluginu pro optimalizaci SEO zakázat přidávání značky metadat Robot na tyto stránky. V doplňku Vše v jednom SEO Pack - část „Nastavení indexování (noindex)“.

Poté bude nutné ze souboru robotů odstranit odpovídající směrnice o zákazech..

Tímto způsobem můžete uzavřít potřebné stránky před indexováním. Pouze aby se zbavil duplicitní repliky, bude muset použít jednu z metod, které jsou popsány v tomto článku. Kromě použití přesměrování a pluginů bude také možné uzavřít odkazy z komentářů ve značce rozpětí tak, aby nebyly indexovány vyhledávacími nástroji..

Po dokončení nastavení budete čas od času sledovat proces odstraňování duplicitních stránek z webu.

Závěry článku

Webmaster by měl věnovat pozornost přítomnosti duplicitních stránek webu, a pokud jsou nalezeny, přijmout opatření k jejich odstranění z výsledků vyhledávání, protože negativně ovlivňují propagaci webu. Z tohoto důvodu mohou být na stránky uvaleny sankce ve vyhledávačích..

Související publikace:- Jak přenést web na HTTPS

- Jak zvýšit návštěvnost webových stránek

- Jak nainstalovat reklamy na web

- Přehled rychlého hostování AdminVPS

- Doplněk Breadcrumb NavXT - strouhanka pro web